| id_answer | r_it | P | n |

|---|---|---|---|

| response_1 | 0.58 | 0.95 | 180 |

| response_2 | 0.60 | 0.89 | 180 |

| response_3 | 0.72 | 0.84 | 180 |

| response_4 | 0.63 | 0.88 | 180 |

| response_5 | 0.38 | 0.58 | 180 |

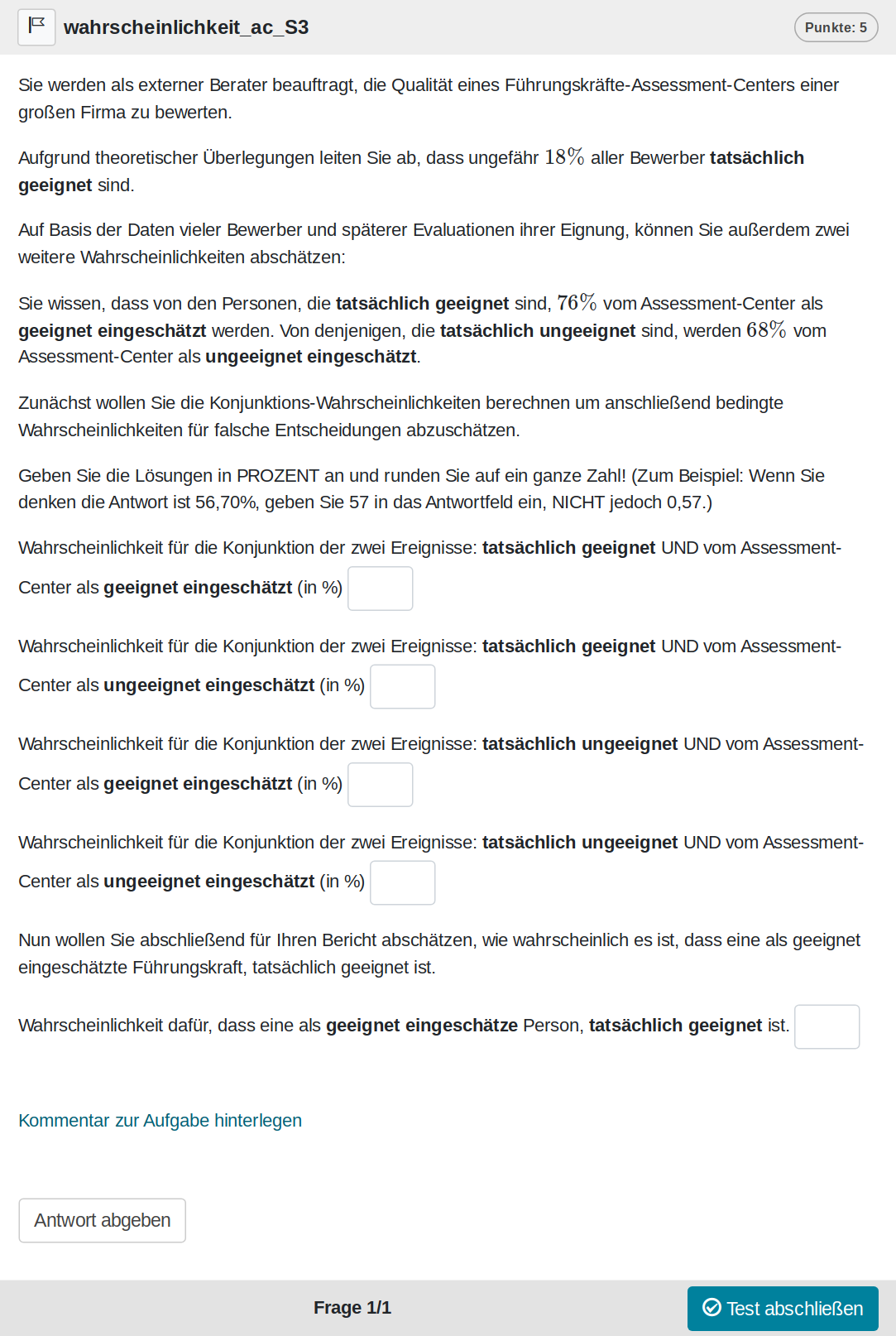

Das Bayes-Theorem anzuwenden ist eine klassische Aufgabe aus der Statistik. In der Psychologie spielt das Bayes-Theorem auch eine wichtige Rolle und wird bei uns daher schon im ersten Semester gelehrt. Mit der Aufgabe bayes decken wir das Bayes-Theorem ab.

Die Aufgabe ist angelehnt an fourfold aus dem exams-Paket, welches unter GPL2/GPL3 veröffentlicht wurde.

Eine Zufallsvariante der Aufgabe sieht wie folgt aus:

Und kann auf Opal auch direkt ausprobiert werden: Link

Für diese Aufgabe werden alle Berechnungen im Feedback angezeigt. Bei Bedarf können weitere Details mit Studierenden in Übungen besprochen werden.

Die Aufgabe ist natürlich auch Bestandteil des Übungskurses: https://bildungsportal.sachsen.de/opal/auth/RepositoryEntry/38156107780/CourseNode/1707104009582858012

In diesem Fall ohne Modifikationen.

Auch für die Klausur verwenden wir momentan die selbe Version. In der Zukunft könnte man einen Teil der Lösungen vorgeben um den Zeitaufwand zu reduzieren.

Validierung

Die Aufgabe kam in zwei Varianten in Klausuren zum Einsatz, ist jedoch erst seit Kurzem im Übungskurs enthalten. Da die Auswertung mittlerweile voll automatisch läuft, gibt es aber hier trotzdem schon mal die Vorschau aus dem Übungskurs (r_it ist die Trennschärfe, P die Itemschwierigkeit):

Die Bearbeitung der Aufgabe liegt bei 417s.

Die Trennschärfen sind durchweg gut, wobei die letzte Frage den geringsten Wert aufweist und die geringste Lösungsrate besitzt. Diese letzte Frage ist abhängig von zwei vorherigen, weshalb sie in Klausreinsichten auch häufig nochmal auf Folgefehler geprüft werden muss.

Die Lösungsraten sind recht hoch, was sicher auch durch wiederholtes Üben zustande kommt. Da der Kurs öffentlich zugänglich ist, können wir Mehrfach-Teilnahmen nicht erfassen. Entscheidend ist aber sowieso die Lösungsrate in Klausuren.

In 2 Klausuren wurde die Aufgabe validiert. 2022 gab es nur die ersten vier Fragen, man musste also die Revision nicht machen, sondern nur Konjunktionswahrscheinlichkeiten berechnen. 2023 wurden alle Fragen gestellt.

Das \(N\) über die 2 Klausuren hinweg beträgt 246. Die folgende Tabelle zeigt die Lösungsraten (P) und Trennschärfen (r_it) aggregiert über die verschiedenen Versionen in 2 Klausuren. Zusätzlich wird auch die Dauer der Bearbeitung in Minuten angezeigt.

| year | GROUP | r_it | P | dur | n |

|---|---|---|---|---|---|

| 2022 | 1 | 0.37 | 0.65 | 831.22 | 23 |

| 2022 | 2 | 0.55 | 0.56 | 827.58 | 31 |

| 2022 | 3 | 0.51 | 0.56 | 965.54 | 28 |

| 2022 | 4 | 0.58 | 0.57 | 780.77 | 31 |

| 2023 | 1 | 0.66 | 0.60 | 1421.10 | 42 |

| 2023 | 2 | 0.28 | 0.59 | 1342.00 | 27 |

| 2023 | 3 | 0.29 | 0.70 | 1694.81 | 31 |

| 2023 | 4 | 0.17 | 0.59 | 1613.33 | 33 |

Die Aufgabe ist tatsächlich eher als schwer zu bewerten. Die Trennschärfe ist für 2022 gut, für 2023 schwankt sie sehr stark. Außerdem ist die Bearbeitungszeit 2023 fast doppelt so hoch, obwohl nur ein Item dazukam. Die doch recht kleinen Gruppen können zu extremen Ergebnissen führen. Beispielsweise performen SeKo-Studierende ungefähr 2 Notenabschnitte (0.7) schlechter als Psychologen; 2023 hatten wir ungefähr doppelt so viele SeKo-Studierende wie 2022. Wenn diese zufällig ungünstig auf die Klausurversionen aufgeteilt wurden, kann dies zu extremeren Trennschärfen führen.

Die zusätzliche Frage 5 hat allerdings eine geringe Trennschärfe mit der Gesamtaufgabe im Übungskurs, was auch die Trennschärfe der Aufgabe zur Klausur beeinträchtigen könnte.

Das sind natürlich Spekulationen und es bleibt abzuwarten, ob sich die Aufgabe in den nächsten Jahren bewährt. Trotzdem deckt die Aufgabe eine wesentliche Kompetenz ab und erhöht die Inhaltsvalidität.

Hier sind noch die Daten aggregiert über die Klausuren. m: mean, sd = standard deviation

| year | r_it_m | r_it_sd | P_m | P_sd | dur_m | dur_sd | n_m | n_sd |

|---|---|---|---|---|---|---|---|---|

| 2022 | 0.51 | 0.10 | 0.58 | 0.04 | 849.66 | 79.56 | 28.63 | 3.77 |

| 2023 | 0.38 | 0.21 | 0.62 | 0.06 | 1516.53 | 164.03 | 34.16 | 6.34 |

Eine Analyse auf Itemebene wäre eine sinnvolle Ergänzung für die Zukunft.

Die Aufgabe sollte nur genutzt werden, wenn das Bayes-Theorem auch Inhalt der Lehre ist. Die Bearbeitung der Aufgabe liegt bei ungefähr 25 Minuten für alle 5 Fragen.

Aufgabe in R nutzen

Der folgende Code erzeugt 20 Versionen mit Seeds 1 bis 20.

aufgaben <- bayes(seed = 1:20)Diese könnten jetzt z. B. in eine Sektion gepackt werden, aus der man eine Variante zieht:

section <- new("AssessmentSection", assessment_item = aufgaben, selection = 1)Und der finale Test:

test <- new("AssessmentTest", identifier = "bayes",

section = list(section))Modifikationen der Aufgabe sind nur begrenzt sinnvoll, können aber über die Hilfsfunktionen im Paket methodenlehre vorgenommen werden. In der Zukunft wäre es gut die Aufgaben weiter zu abstrahieren, sodass man die Szenarien leicht variieren kann. Beispielsweise ist es recht typisch die Diagnostik bei Erkrankungen als Szenario zu wählen.

QTI zum Download

Den Test den, wir oben erzeugt haben, können wir nun auch als QTI-Datei schreiben:

createQtiTest(test, ".", verification = TRUE, zip_only = T)[1] "./bayes.zip"Über verification wissen wir, dass es eine valide QTI-Datei ist. Und mit zip_only bekommen wir nur die gezippte Datei.

Diese Datei kann man jetzt in Learning-Management-Systeme, die QTI 2.1 unterstützen, importieren. Unter Opal wäre es dann auch möglich diesen Test in andere Tests zu inkludieren. Beispielsweise wenn man als Dozent schon eine Klausur erstellt hat und diese um unsere Aufgabe erweitern möchte. Standardmäßig bekommen die Studierenden zufällig eine der 20 Varianten zugeteilt.