| id_answer | r_it | P | n |

|---|---|---|---|

| response_1 | 0.36 | 0.83 | 179 |

| response_2 | 0.37 | 0.78 | 179 |

| response_3 | 0.43 | 0.79 | 179 |

| response_4 | 0.37 | 0.78 | 179 |

| response_5 | 0.43 | 0.33 | 179 |

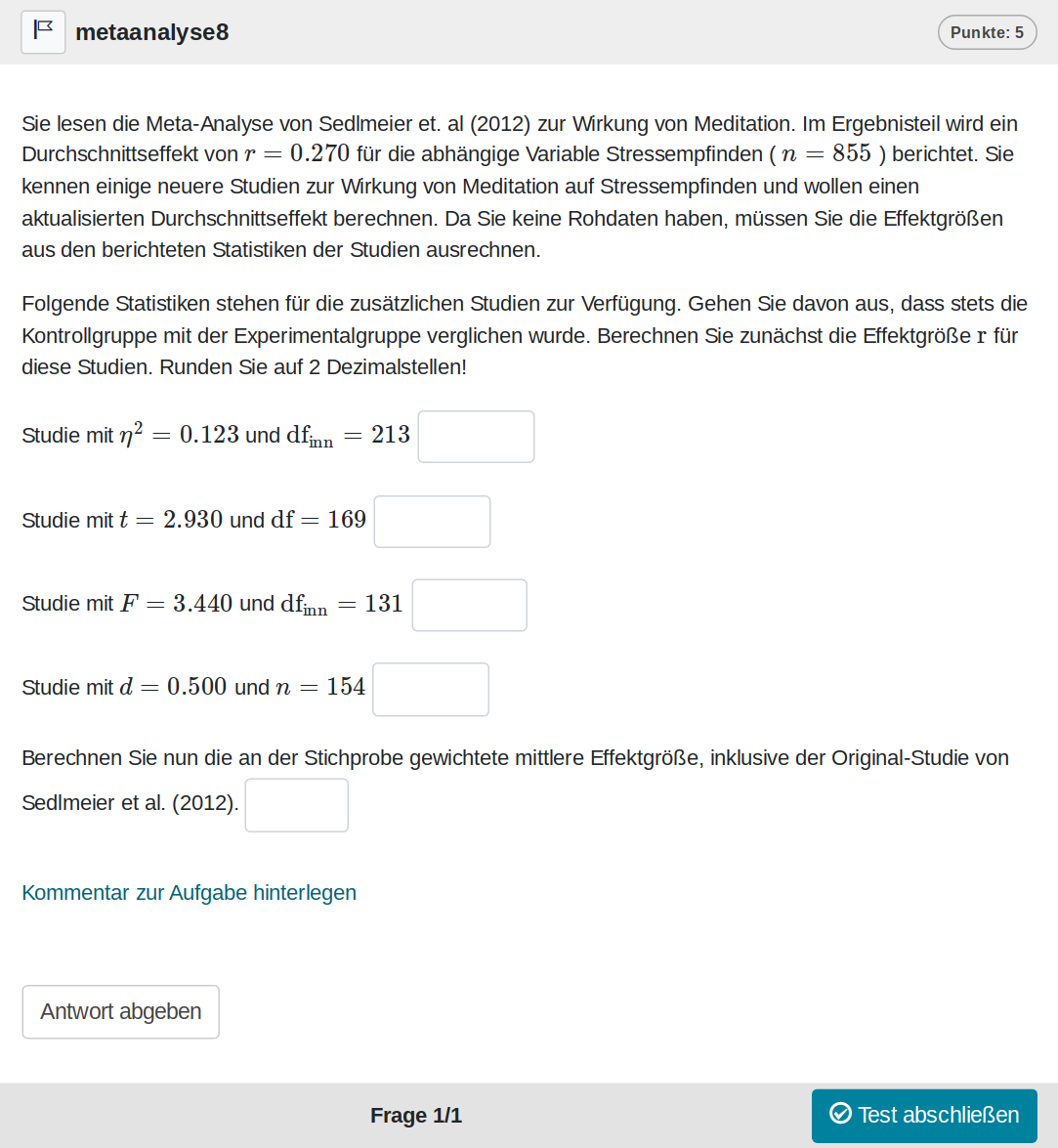

Bei dieser Aufgabe geht es um die Umrechnung von Effektgrößen in eine einheitliche Effektgröße und die anschließende Berechnung des mittleren gewichteten Effekts. Es ist quasi eine Mini-Meta-Analyse. Ausgangspunkt ist ein echter Durchschnitts-Effekt aus einer Meta-Analyse, der um neue fiktive Effekte ergänzt werden soll.

Eine Zufallsvariante der Aufgabe sieht wie folgt aus:

Und kann auf Opal auch direkt ausprobiert werden: Link

Für diese Aufgabe werden alle Lösungen im Feedback angezeigt. Bei Bedarf können weitere Details mit Studierenden in Übungen besprochen werden.

Die Aufgabe ist natürlich auch Bestandteil des Übungskurses: https://bildungsportal.sachsen.de/opal/auth/RepositoryEntry/38156107780/CourseNode/1691461670273510008

In diesem Fall ohne Modifikationen.

Validierung

Die Aufgabe ist noch nicht so lange in unserem Kanon, daher haben wir im Übungskurs nur einige Daten sammeln können. In einer Klausur kam die Aufgabe bisher nur ein Mal zum Einsatz. Zunächst die Übungsaufgaben (r_it ist die Trennschärfe, P die Itemschwierigkeit):

Die Bearbeitung der Aufgabe liegt bei 569s.

Die Trennschärfen sind in Ordnung, das letzte Item ist jedoch auffällig schwierig. In den ersten 4 Items rechnet man die Effektgrößen um, beim letzten Item berechnet man den durchschnittlichen Effekt.

Für die Beurteilung der Aufgabe, ist eine Klausur natürlich aussagekräftiger:

| id_question | r_it | P | dur | n |

|---|---|---|---|---|

| metaanalyse | 0.67 | 0.74 | 891.35 | 98 |

Die Trennschärfe ist ausgezeichnet, eine, der höchsten, die wir je erreicht haben. Die Lösungsrate ist in einem guten Bereich, tendenziell eher geringer als bei anderen Aufgaben. Schauen wir uns noch die Analyse auf Item-Ebene für die Klausur an:

| id_answer | r_it | P | n |

|---|---|---|---|

| response_1 | 0.65 | 0.81 | 102 |

| response_2 | 0.64 | 0.76 | 102 |

| response_3 | 0.57 | 0.73 | 102 |

| response_4 | 0.65 | 0.55 | 102 |

Hier sehen wir, dass alle Items prädiktiv für das Klausurergebnis sind. Aber warum sind es nur 4 Items? Ein Item mussten wir für die Klausur rausnehmen, weil Studierende die Effektgröße Eta-Quadrat noch nicht kannten. Leider ist die Beschriftung noch aus dem alten System, in der aktuellen Form der Aufgabe haben wir sinnvollere ids gewählt.

Die Trennschärfen sind sehr gut und unterscheiden sich kaum. Die letzte Frage ist aber trotzdem deutlich schwieriger. Gleichzeitig ist diese Frage abhängig von den anderen. Dies führt dazu, dass es gehäuft Anträge auf erneute Prüfung der Klausur gibt. Studierende weisen teilweise willkürlich auf einen Folgefehler hin. In Zukunft werden wir entweder eine dynamische Lösung abhängig von den anderen Antworten erzeugen, oder die letzte Frage in Klausuren nicht stellen. Dadurch erhöht sich zwar die Lösungsrate, aber man könnte die Frage bei einem anderen Beispiel stellen, um dies auszugleichen.

Aufgabe in R nutzen

Wir erstellen 20 zufällige Versionen der Aufgabe:

library(methodenlehre)

aufgaben <- metaanalyse(1:20)Diese könnten jetzt z. B. in eine Sektion gepackt werden, aus der man eine Variante zufällig zieht:

sektion <- section(aufgaben, selection = 1)Und der finale Test:

test <- test(identifier = "metaanalyse", content = sektion)Weitere Details zur Aufgabenerzeugung kann man entsprechend im methodenlehre-Paket nachlesen.

QTI zum Download

Den Test, den wir oben erzeugt haben, können wir nun auch als QTI-Datei schreiben:

createQtiTest(test, ".", verification = TRUE, zip_only = T)[1] "./metaanalyse.zip"Über verification wissen wir, dass es eine valide QTI-Datei ist. Und mit zip_only bekommen wir nur die gezippte Datei.

Diese Datei kann man jetzt in Learning-Management-Systeme, die QTI 2.1 unterstützen, importieren. Unter Opal wäre es dann auch möglich diesen Test in andere Tests zu inkludieren. Beispielsweise wenn man als Dozent schon eine Klausur erstellt hat und diese um unsere Aufgabe erweitern möchte.